10倍速の効率に専門医レベルの回答精度―医師はChatGPTなどの生成AIをどう扱うべきか?

「医師による医師のためのChatGPT入門 臨床がはかどる魔法のプロンプト」著者インタビュー

大塚 篤司 氏(皮膚科医/近畿大学医学部皮膚科学教室主任教授)

簡単な指示文(プロンプト)を入力するだけで、専門家のような文章や画像などを即座に回答する生成AI。2022年にOpenAI社が発表したChatGPTに始まり、精度や機能のめざましい進歩とともに各業界で存在感を増しています。

医療分野でも、生成AIへの期待は高まっています。しかし、中には使い方がわからなかったり、安全性の懸念がぬぐえなかったりして活用に踏み切れない医師の方もいらっしゃるのではないでしょうか。

「確実にできることは増えるし、仕事が早くなります。作業速度は体感”10倍速”」と生成AI活用による驚異的な変化を語るのは、2024年6月に「医師による医師のためのChatGPT入門 臨床がはかどる魔法のプロンプト」を出版し、医師の業務を効率化するノウハウを数多く紹介している大塚篤司先生です。

ChatGPTなどの生成AIは医師の仕事に使えるレベルに達しているのか、また活用時に注意すべきことは何かなど、医師の生成AI活用について大塚先生に聞きました。

※2025年2月に第2回の大塚先生への生成AIに関するインタビューが公開されました。こちらも合わせてご覧ください。

「既に大学教授クラス」大塚篤司医師が驚愕したChatGPTの進化 人間の医師に残される役割とは?

現状の生成AIは「専門医といい勝負をしそうなレベル」

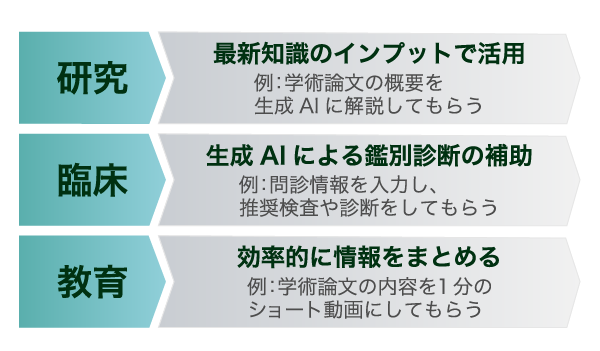

――医師の業務を臨床・研究・教育に分類した場合、ChatGPTはどの分野で特に力を発揮できるとお考えですか。

それぞれの分野で使い道はあると思います。今は研究分野に活用しやすいんです。

論文を解説してもらうなど、知識のインプット時に、個人情報を扱わないで済むというところが大きなメリットです。制限なく、医者としての守秘義務に反さずに使えるので、研究に使う場面が一番多いなと思います。

ただ、臨床でも当然使えるんですよね。今試しているのは、生成AIによる診断の補助です。たとえば専門誌に出ているような疾患の症例報告から、病歴のところだけ取り出します。年代、性別、こんな主訴があって、こんな症状があって、という部分です。その情報を生成AIに入れて鑑別診断を聞くと、回答してくれるんですよ。つまり生成AIによる診断ができる。

僕は今、これをいろんな種類の生成AIで試しているんですが、専門医といい勝負しそうなレベルまでいっている気がしますね。特に難しい症例とかでは。

――専門医レベルとは、かなり診断の精度が高いですね。

生成AIが賢くなってきていると感じています。ChatGPT3.5の時はちょっと精度が低くて、ChatGPT4も「全然医者の方が強いな」と思ったんですけど、ChatGPT4o(オムニ)とかClaude3.5Sonnetとかは、使ってみると賢いなと感じます。

だから、今まで医者しかできなかった診断が、生成AIにできてしまう。患者さんの個人情報をうまく省いて生成AIを使うことができれば、臨床でもめちゃめちゃ使えるんです。

――鑑別診断で使えるとのことでしたが、珍しい症例から一般的な症例まで様々なものがあるかと思います。どういう部分で特に使えるのでしょうか。

臨床分野での診断という使い方は2通り考えられます。

ひとつは、自分の専門外の診断であたりをつける時。例えば内科の先生が皮膚科は診られないと思うんですけど、どうやら帯状疱疹らしき症状の患者さんや、よくわからないぶつぶつの症状が出ている患者さんが来院されることもあります。

そんな時にぶつぶつの写真を撮って、経過を書いたら、電子カルテが診断と今後の検査と治療をあげてくれる、というシステムの開発はそんなに難しくないと思います。

――医師不足問題にも関わってきそうですね。

地方など、例えば内科の先生1人しかいないという状況だとすごく助かるんじゃないですか。このまま精度があがっていけば、いろんな科の診断をAIが代わりにやってくれるので。

もう既に画像系はあるじゃないですか。レントゲンやCTをある程度読んでくれたりとか、内視鏡でも病変を見つけてくれたりとか、進んでいますよね。

同じように、問診をとったら診断と検査と治療が電子カルテ上でばっとあがって、医師1人である程度対応できるようになるっていうことは今後あり得るんじゃないでしょうかね。

――臨床分野でのもうひとつの活用方法はどんなものでしょうか。

もうひとつは、専門家が自分が頭の中で思っている診断を確認するとか、漏れがないかを確認する鑑別診断で使われると思っています。

患者さんの疾患として頭に上げなきゃいけない鑑別診断の選択肢が、やっぱり人間だと漏れちゃうこともあります。ChatGPTとか生成AIだと、ちゃんとそれが網羅されるので、チェックできるというのはあるかな、と思います。

――教育に関してはいかがですか。

教育面では、現状活用している人は少ないですけど、使えるんじゃないかなと思います。僕が考えているのは、例えば論文を生成AIにアップロードすると1分のショート動画を作ってくれる機能の活用ですね。読み上げてくれて、動画にしてくれて。まずは概要を押さえるショート動画を作る、という使い方を検討中です。

生成AIに関する論文を読んでいると、ChatGPTは教育系の論文が多いので、教育への活用は進んでいるんじゃないですかね。

生成AIの落とし穴に注意―回答の正誤確認と個人情報管理

――ChatGPTなどの生成AIを使う上での注意点は何でしょうか。

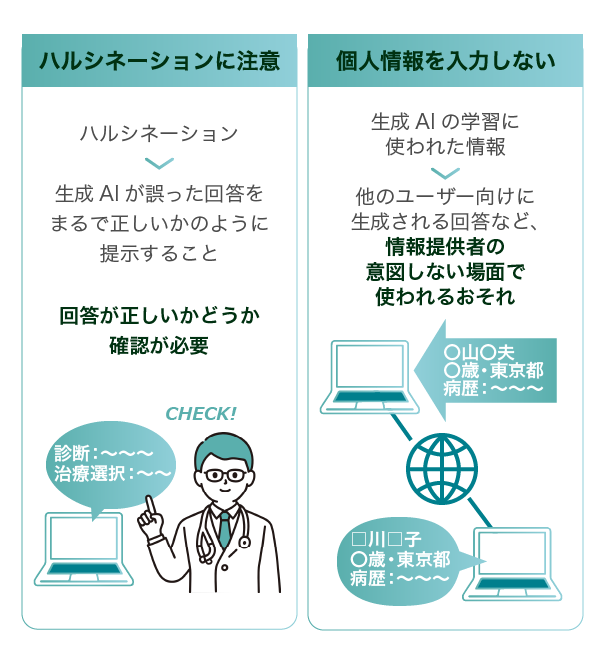

ChatGPTはやっぱり嘘をつくので、ハルシネーションには気を付けるということ。あと、個人情報を入力しないという2点です。

――先ほど臨床分野で専門外の鑑別診断に活用できるとおっしゃいました。ハルシネーションへの対処として、生成AIの出した診断結果が正しいかどうか、専門外の医師が判断するにはどうすればいいでしょうか。

実は、今はそれはまだ難しいんです。精度がまだ高いレベルで一定していないので、生成AIの出した診断結果に対して専門家が知識を持って答え合わせをしないと、使える状況ではないですね。

専門外の先生で、返ってきた答えの正誤が分からない場合、判断はできないと思います。

ただ、今の生成AIの成長度合いを見ると、この先かなり精度が高い返事が返ってくるものができてくると思います。9割は合っている鑑別診断が返ってくるというような生成AIが出てくれば、また使い方が異なってくるでしょうね。

今はまだ難しいとは思いますけど、おそらくあと1~2年すればわりと正確な診断が返ってくるようになると思うので、生成AIの鑑別診断を十分参考にすることができる未来が来るのも時間の問題かなと感じています。

――研究分野で、医学的なハルシネーションを起こしていないかチェックする時は、どんな対処法がありますか。

医学情報を探し出すことに特化した拡張機能を使えば、チェックしやすくなります。

ChatGPTだったら、GPTbuilder、通称GPTsというカスタマイズツールが便利です。回答の生成に使うデータを学術論文のみに限定できるSciSpace(サイスペース)やConsensus(コンセンサス)を使うと、回答の引用文献が出てくるので、ファクトチェックができます。

そのままChatGPTに聞くのではなくて、目的に合ったGPTsを活用することでハルシネーション対策ができると思います。

医局員(右)に生成AIの使い方を指導

――個人情報に関しては、どういった問題が考えられますか。

個人情報の漏洩に関して僕が聞いたことがある例えだと、大阪で僕が患者さんの情報を丸ごとそのまま入力して、その情報が北海道の誰かのアウトプットで出てきてしまうことを心配される、というようなケースがあります。患者さんの個人情報が学習されて、どこかで利用されるという場合ですね。

この場合が個人情報漏洩なのかというと微妙で、出力されたとしても名前や疾患、住所が全て出てくるわけではないんですよ。とはいえ、まだ慎重に使うべきだなとは思います。

――個人情報漏洩に気をつけながら生成AIを利用する方法には、どのようなものがありますか。

生成AIのサービス提供企業のサーバーに情報を送信しないよう、ローカル環境で生成AIを使えるようにできれば、個人情報を気にせずに情報を入力できます。

去年から、生成AIを使ってプログラミングの勉強を始めまして。一から自分でコードを書くのが大変なので、だいたい生成AIに書いてもらっていますが、初学者でもローカルで生成AIを動かす環境づくりができました。

――ChatGPTを活用したいと考えている全ての医師がローカル環境を整備することは難しいと思います。そういった方は、例えば学会発表時の資料と同じような感覚で匿名化する必要があるんでしょうか?

これまでも学会発表などで患者の症例を匿名化して利用することはありましたが、生成AIによる診断補助のために情報を活用するとなると、用途がより一般的になります。

どこまでが許容範囲とされるのかについては、現状ルール作りが進んでいません。やはり、患者さんの個人情報は入力しないほうが良いかなと思いますね。

作業は"体感10倍速"、「とてもすごいことが起きた」

――研究分野が一番使いやすいということですが、先生も実際ChatGPTなどの生成AIを最も活用していらっしゃるのは研究分野ですか?

5割以上は最新情報、論文や医療系の情報のインプットに使っていますね。英語の論文など、昔は最初から丁寧に読んでいましたけど、今はダウンロードしたPDFをChatGPTにアップロードして、自分で作ったプロンプトを使って解説してもらっています。

それを読んで概要をつかんで、気になるところがあればまたChatGPTに解説してもらって。元の論文もちょっと見つつですが、だいたい概要が分かります。あとは、書類仕事の下書きはだいたい頼んでいますね。

――体感で、作業の速度はどれくらい変化しましたか?

10倍速くらいになったと僕は感じています。感覚としては、レースゲーム「マリオカート」のコースにあるダッシュボードみたいな感じです。踏むと、ビュンと加速するあれですね。

――大塚先生ご自身がChatGPTを使うようになられたきっかけは?

ChatGPTがリリースされて、初めて使った時に「とてもすごいことが起きた」と衝撃を受けました。同時に「すっごい面白いな」と好奇心も湧いて。

初めの2週間か1か月くらいは、「いったい何ができるのか」というのをずっといじりながら探っていた気がしますね。どういうプロンプトを打ったらどう返ってくるとか、自分の名前を検索してみるとか。GPT3.5の時は「嘘ばっかりつくなぁ」という感じでしたね。

いろいろとやっていくうちに、「これは何ができるんだろう」と考え始めました。専門的なことも意外と正しく答えてくれますし、「全部正解ではないけど、8割がた当たり」みたいな答えも出てきます。「これは上手に使ったらいろいろとできるな」と感じて、とにかく1日中、いろいろな使い方を試していた気がします。

――そうしてご自身で見つけられたChatGPTの使い方を、講演会や先日出版された書籍で惜しみなく公開していらっしゃいます。「多くの医師が活用できるようになってほしい」という思いでご活動なさっているんですか?

使い始めの何か月かは、教えたくない気持ちのほうが強かったですね。使っていくうちに仕事がどんどん効率化されていって、「これを知ったらみんなが同じパフォーマンスになってしまう」っていう思いがあったんですけど。

でも、説明をしてもやらない人もたくさんいるし(笑)、できる人はどんどんみんなやっていく。医者が生成AIを使えない方が世の中的には良くないのかな、という気がしてきたんです。「みんなで生成AIを使って、良い方向に発展させましょう」っていうほうが良い未来かなと思って。「言いたくないなあ」という気持ちは、もう乗り越えましたね。

講演会でも、「ChatGPTを使ったアトピー性皮膚炎の理解の仕方」のように、ChatGPTの活用事例を取り入れています。そうした講演会はもう20回以上はやったかな。まだ医療へのChatGPTの取り入れ方を扱った講演を聴く機会はそう多くないので、皆さん興味を持ってくださいます。

生成AIにはそれぞれの得意分野がある

――生成AIの使い分けはどのようにしていらっしゃいますか?

使い分けは手さぐりで特徴をつかんでいっていますね。

Claudeはすごくきれいな日本語が返ってくるので、日本語でアウトプットしたいときはClaudeを優先します。ChatGPTは万能なので、困ったらChatGPTですかね。

Geminiは、それ自体を使うことはないですが、バックでGeminiが使われているGoogleAIStudioを使うことはあります。僕が一番すごいなと思ったのは、文字起こし機能。たとえば、今日のインタビュー音声をAIStudioにアップロードして、「書き起こしして」と指示したらやってくれますよ。

そのまま「対談として要約して」といったらそれもやってくれます。今日の対談の資料は20分…10分でできます。WhisperというOpenAI社が出している書き起こしAIがあって、僕、ローカル環境でそれを実装して動かしたんですけど、それよりAIStudioのほうが精度が高くて早かったです。対談文ならあっという間にできると思います。

――そういった使い分けは、自分でやってみて見つけていくものなんでしょうか?

SNSやインターネット上で「これいいよ」という情報があったら、まず自分で使ってみて感触を試してみることが多いですね。使っていく中でさらに情報を集めたり、「こんな使い方してみたらどうだろう」と自分なりに試したり。とりあえず自分で動かしてみて、しっくりくる使い方を探す感じですかね。

――「使いこなせるようになるまでの負担感が大きい」と感じる医師も多いのではないでしょうか。

僕は楽しいからずっとやってますけど、もしいろいろと試すのが好きじゃなかったら、誰かが見つけてくれたものを活用するのが一番早いと思います。例えば僕が出版した本のプロンプトはそのまま使えますし。

それに、ちょっと待てば誰かがやってくれるんですよ、これは。日常の診療にはいずれ使いやすい形で入ってくるので、別にそんなにあわてなくてもいいんです。でも、使えたほうが業務ははるかに早くなります。

――生成AIがどんどん進歩していく中で、「こんな機能があったらいいな」と思うものはありますか?

ChatGPTに関して言うと、細かいところになりますが、まだ生成画像の中の文字情報が変なんですよ。

たとえばAIに生成してもらった絵の中にポスターがあったとして、その文字が記号みたいになっちゃうんですよね。これが完璧に文字として出力できると、すごく使いやすいなと思います。

あとはもうちょっと賢くなったらいいなと思いますが、もうちょっと賢くなると自分の職業的な存在意義がなくなってくるので。自分の専門分野でも、結構もうそろそろやばいなと感じています。

◆付録・生成AIと記者の文字起こし能力を比べてみた

大塚先生のご協力を得て、実際に今回のインタビュー音声をGoogle AI Studioにアップロードして文字起こししている動画をご紹介します。

約3分20秒のインタビュー音声を文字起こしするのに、担当記者がかかった時間は約7分。対して、生成AIは23秒と、人力の約18倍の速さで書き起こしを終えています。

生成AIの文章には、発言者の区別がついていない部分や、「えっと」「あー」などの余分な要素がそのまま含まれてしまう点など、精度や使い勝手に少し問題が見られます。しかし、人力に比べて圧倒的に速いため、AIの回答をもとに記者が調整したとしても、すべて記者が文字起こしした場合の1.6倍の速度で作業を終えることができました。

今回のインタビュー音声は約53分だったため、すべて人力で文字起こしした場合と、生成AIの文章を調整した場合では、かかる時間の差は単純計算で約1時間にもなります。こういった単純作業は全て人力で進めるより、生成AIを活用したほうが効率的であることが検証できました。

医師にとって当たり前のツールへ…まだハードルも

――ここまで、生成AIの現状や功罪についてお話しいただきました。では、実際に現役医師が医療分野での生成AI活用に対してどう感じているのか、大塚先生のご意見もおうかがいしつつ見ていきます。

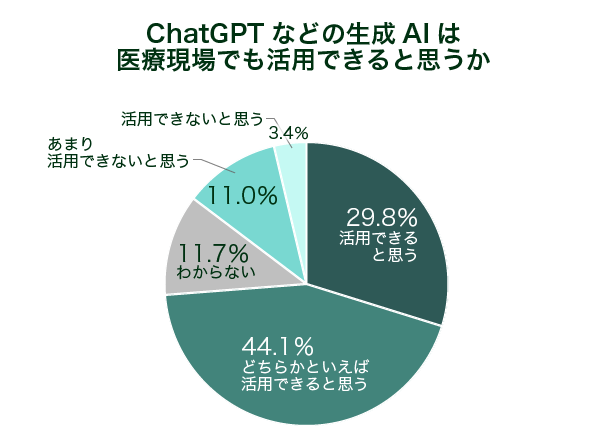

弊社が昨年10月に調査したアンケートでは、7割以上の医師が「ChatGPTなどの生成AIを医療現場で活用できると思う」と生成AIに期待を寄せています。

これは僕、もっと活用できるんじゃないかなと思っています。例えば紹介状の作成とか、退院サマリなどは、近い将来電子カルテ自体に生成AIが実装されて、簡単にできるようになると思います。

インターネットを経由せずに使うことができれば、患者さんの個人情報保護の問題をクリアできるじゃないですか。僕も自分で、生成AIを使う時に情報をサーバーに上げずに済むようなローカル環境を準備しています。僕がやっているということは、電子カルテの会社も当然準備をしているはずです。

電子カルテに患者さんの情報を入力していくと、そこで鑑別診断や推奨の検査があがってくる未来はそう遠くないと思います。

――ローカル環境で生成AIを使えるようになれば、通常の医療機関の情報管理と同じ感覚で対処できるということでしょうか?

そうです。病院の中のサーバーでやればいいだけなので。それは僕ら医師が努力をしなくても、電子カルテの企業が近い将来、生成AIを取り入れると思います。

「仕組みはよく分からないけど、カルテのこのボタンを押したら紹介状のテンプレートが今までのカルテ内容からぱっと書きあがってくる」とか、「ボタンを押したら退院サマリがばっとできあがってくる」というような電カルができるでしょうね。

医師が生成AIの活用方法を理解して使うよりも、出来上がってきたシステムを使うようになる方が先だと思います。

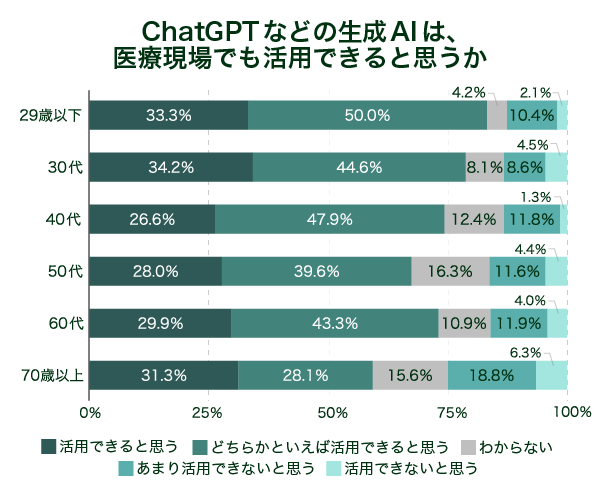

――多くの医師が期待を寄せる一方で、世代が上がるにつれて、「分からない」「活用できないと思う」という回答が増加しています。

それはしょうがないですよね。僕は、携帯がスマホにかわるのと同じくらいの感覚を持っているんです。とても便利になるし、何でもできるようになる。もうちょっとみんなが使いやすいようになってくるとは思うんですけど。

でも「やっぱりガラケーがいい」っていう人は年配の人で増えちゃうし。「スマホ、よくわからない」っていう人も増える。それと同じような感じで、結構みんなが当たり前に使うツールになると思うんですけど、やっぱりまだそこはハードルがあるんだと思います。

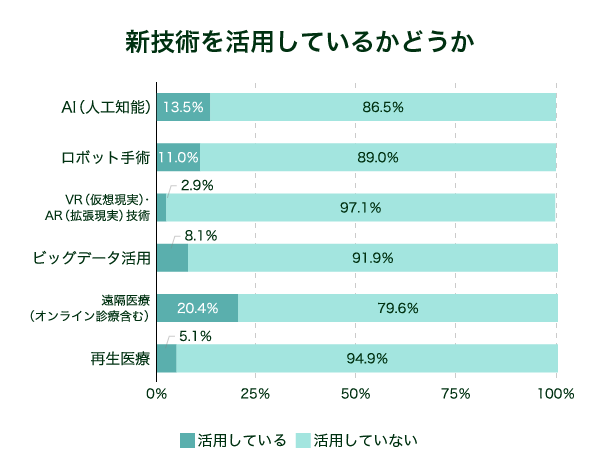

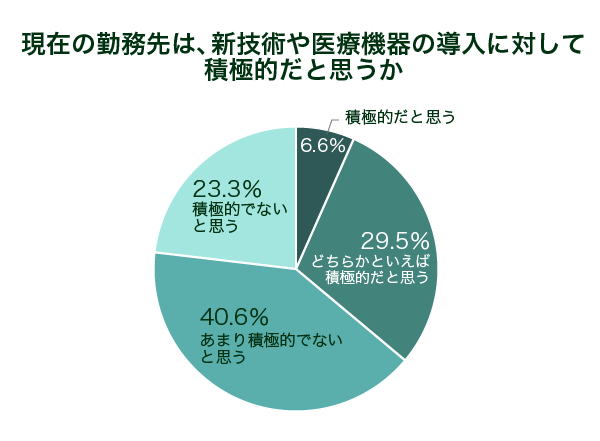

――また、期待と現状の乖離も見られます。「勤務先でAIを活用している」回答は13.5%とかなり少ない状況です。AIの医療現場での活用は進んでおらず、また導入にも積極的でないことがわかっています。

おそらくこれは生成AIに限らないAI全般についての状況だと思いますが、もったいないな、と思います。「やってみたいけどよくわからない」とか「ちょっとこわい」、「一回触ってみたけどどう使っていいかわからない」っていうのもあるんでしょう。なかなか導入のハードルは高いかなと思います。

――生成AIなどの新技術活用の取り組みは大学病院のほうが早いイメージでしょうか?

おそらく、大学だと安全面などから扱い方を指導する講習会があるケースが多く、触れる機会も多いんじゃないでしょうか。大学病院は他の医療機関だとあまりやられていないような研修があるので。それでちょっとなじみがあるのかもしれないですね。

理想は”できることを手伝ってもらう”使い方

――研究分野に関して、アウトプット面で多用してしまうと医師の能力を高める機会が失われるように思いますが、いかがですか?

アウトプットに関しては難しいなと思います。これって、パソコンが使える時代に手書きはどうなの、みたいな議論と同じだと思うんですよ。

そして、使うなと言っても便利なものって使っちゃうじゃないですか。だから、例えば漢字を書くことが手書きからパソコンに変わったように、文章を書くという行動のベースが、もしかしたらもう生成AIを使うことになるかもしれない。

我々人間は一から文章を書くということをやらなくなって、書けるけど生成AIに頼むケースが多い、ということになっていくのではないかな、と。

今回、ChatGPTの本は自分で書いたんです。AIを使ってないんですよ。ただ、AIを使っても下書きが書けるなとは思います。プロンプトを工夫すれば、現状の生成AIでも相当優秀な文章が書けます。AIチェッカーにもひっかからない文章も可能です。

そして、そっちのほうがはるかに速い。生産性はすごく上がりますが、そうやってAIに優秀な回答を返させる技術を磨くことが良いことなのかと言われると、自分ではわからない。

例えば学術論文にしてもエッセイにしてもコラムにしても、結局できあがってきたものが良いか悪いか判断するのは我々人間じゃないですか。その目を養っていない状態で使うということが、その人にとってプラスなのかはちょっと疑問です。できることを頼むのはありだと思うんですけど、できないことを全部やってもらうっていうのはどうなんだろうと思ってしまいます。

最低限自分で学習はしたうえで、ある程度自分ができる部分で、ルーティンワークだとか、手間だけかかるところを生成AIに手伝ってもらうのが理想でしょうね。ただ、プログラミングに関しては僕はほぼ自分の能力以上のことをやってもらっているので…。現実としては能力以上のことができてしまう。

――能力以上の結果を出すために、自分の専門分野に関して使いすぎるのは良くないかもしれませんが、達成したいことのために専門外の部分に関して少しだけ使いたい、という人にとってはプラスになる技術だと感じます。

僕も、個人的には良いことだと思いますよ。できることが増えるし、やりたいことがもっとやりやすくなりますしね。

ただ、例えば僕はプログラミングに関して、ChatGPTのおかげで色々難しいことができるようになりました。僕はうれしいけれど、エンジニアの人がどう思うかというと、「そんなの一から勉強してやるべきだ」と当然なりますよね。

医療も同じで。自分の能力以上のことができることに対して、自分はとてもうれしいですけど、じゃあそれが果たして正しいことなのかと言われると、まだわからないなと思います。

医師はAIを味方にして、より患者と向き合う仕事へ

――生成AIを臨床に取り入れた場合、医師の仕事はどう変化するのでしょうか。

もし僕が生成AIをすごく悪く使おうと思ったら、医者は1人だけ。あとは全部AIを働かせて、患者さんはAIとの対話を基本にして、診断、治療までAIがたてて、医者は最後ハンコを押すだけという使い方もできてしまう。

例えば悪徳な病院の経営者、院長になったとして。「この病院は総合病院です、それぞれ特化したAIがいます」と謳う。最後のハンコを押すのは1人の医者が全部やって、それで病院を動かしてます、という「全AI病院」経営も当然できるわけです。

生成AIを特化させて学習させたらいいだけじゃないですか。皮膚科、眼科、耳鼻科…。診断と治療を、できるところまでAIでやれば、人件費が削減できます。

国民にとって良いか悪いかは別として、医者にとって望ましくない未来が待っている可能性もあるかなと思います。

医師の必要数が減りますよね。看護師さんの方が残るんじゃないですか?お医者さんは司令塔で、司令塔は一つあれば別に良い。それがAIに変わったら良いだけで、あとは誰が責任を取るかだけじゃないですか。正直、数は減らせるなと思います。でも、数が減ったら困るなあとも思いますけどね(笑)。

また、「生成AIに聞いたら自分の診断と治療はこうでした」とおっしゃる患者さんが出てくることもありうると思います。

昔インターネットが使い始められた頃に、「インターネットで調べて来ました」という患者さんが増えて、医者が困った、みたいなことがありました。そのAI版が出てくる可能性はあります。

だから、早い段階から我々医者は、逆にAIを味方に付けるべきで。患者さんが生成AIに診断を聞いてから受診してきたとして、医者が頭ごなしに「こんなの信じちゃだめだよ」と言うのは良くないです。

理想的なのは、僕らが生成AIを身近に置いておいて、「生成AIはこう言っているけど、あなたの場合はメリットデメリットを考えたらこっちの治療法のほうがいい。だからこっちにしませんか」みたいなことを提案するような使い方。

患者さんと医者と生成AIで話して、その人に合ったやり方で医療を進めていくのが良いのかなと思います。

(聞き手・文=エピロギ編集部)

※2025年2月に第2回の大塚先生への生成AIに関するインタビューが公開されました。こちらも合わせてご覧ください。

「既に大学教授クラス」大塚篤司医師が驚愕したChatGPTの進化 人間の医師に残される役割とは?

【関連記事】

・大塚篤司氏に聞く「バーンアウトしない・させない」医師の働き方~かつてバーンアウトを経験した病棟医長の考える、医師を“楽しむ”ために必要なこと

・医師の仕事は新技術の活用でどのように変わるのか?-医師1,578人のアンケート結果

- 大塚 篤司(おおつか・あつし)

- 1976年生まれ。近畿大学医学部皮膚科学教室主任教授。

医学博士、日本皮膚科学会専門医・指導医、がん治療認定医、日本アレルギー学会認定専門医。

2003年信州大学医学部卒、京都大学医学部特定准教授(病棟医長)などを経て、2021年より現職。

アレルギー薬剤開発研究にも携わり、複数の特許を取得。がんやアレルギー、生成AI活用の講演活動やコラムの執筆も手掛ける。

著書に『医師による医師のためのChatGPT入門-臨床がはかどる魔法のプロンプト』(医学書院)、『世界最高のエビデンスでやさしく伝える 最新医学で一番正しいアトピーの治し方』(ダイヤモンド社)、『白い巨塔が真っ黒だった件』(幻冬舎)など。

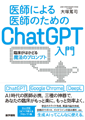

- 『医師による医師のためのChatGPT入門

臨床がはかどる魔法のプロンプト』 - 著者:大塚篤司

発行所:医学書院

発行日:2024年6月

目次:

▪ Web付録「おーつか先生のプロンプト集」について

▪ プロローグ

初級編

・ ChatGPTは学会抄録を作れるのか?

・ ChatGPTの落とし穴①…等

中級編

・ ChatGPTを使ってガイドラインを読み解く

・ ChatGPTを使って紹介状や退院サマリーの作成は可能か?…等

実践編

・ 学会発表のスライド作成①

・ 英語論文(症例報告)の作成①…等

内容:ChatGPTの登場後、難しそうと敬遠する医師がいる一方、日常業務を効率化し生産性を上げている医師もいる。本書は、ChatGPTに苦手意識のある医師や研修医に向けて、ChatGPTを中心とした生成AIの基本的な使い方から日常業務での活用法に至るまで具体例とともに解説する。おーつか先生から研修医・花咲アイさんへのレクチャー形式で展開。コピペでそのまま使える、著者秘伝のプロンプトを集めたWeb付録付。(出版社コメントより)

公式SNS

公式SNS

コメントを投稿する